SiliconCloud 是什么?

SiliconCloud 是由硅基流动推出的一站式大模型云服务平台,通过提供更快、更便宜、更全面的主流开源大模型 API 服务,SiliconCloud 希望能打造“大模型 Token 工厂”,帮助开发者真正实现 “Token 自由” 。目前,平台已上架包括 DeepSeek-V2-Chat、DeepSeek-Coder-V2、Stable Diffusion 3 Medium、Qwen2、GLM-4-9B-Chat、SDXL、InstantID 在内的多种开源大语言模型、图片生成模型与代码生成模型。

其中,Qwen2 (7B)、GLM4 (9B)、Yi1.5(9B)等顶尖开源大模型永久免费。

立即体验:https://siliconflow.cn/zh-cn/siliconcloud

SiliconCloud 的产品特点

优质模型服务

- 文本生成:SiliconCloud 基于优质的大语言模型提供服务,包括 Llama3、Mixtral、Qwen、Deepseek 等,为用户提供超快的模型访问体验。

- 图片生成:SiliconCloud 包含各种文本到图像和文本到视频模型,例如 SDXL、SDXL lightning、photomaker、 instantid 等。

简单易用

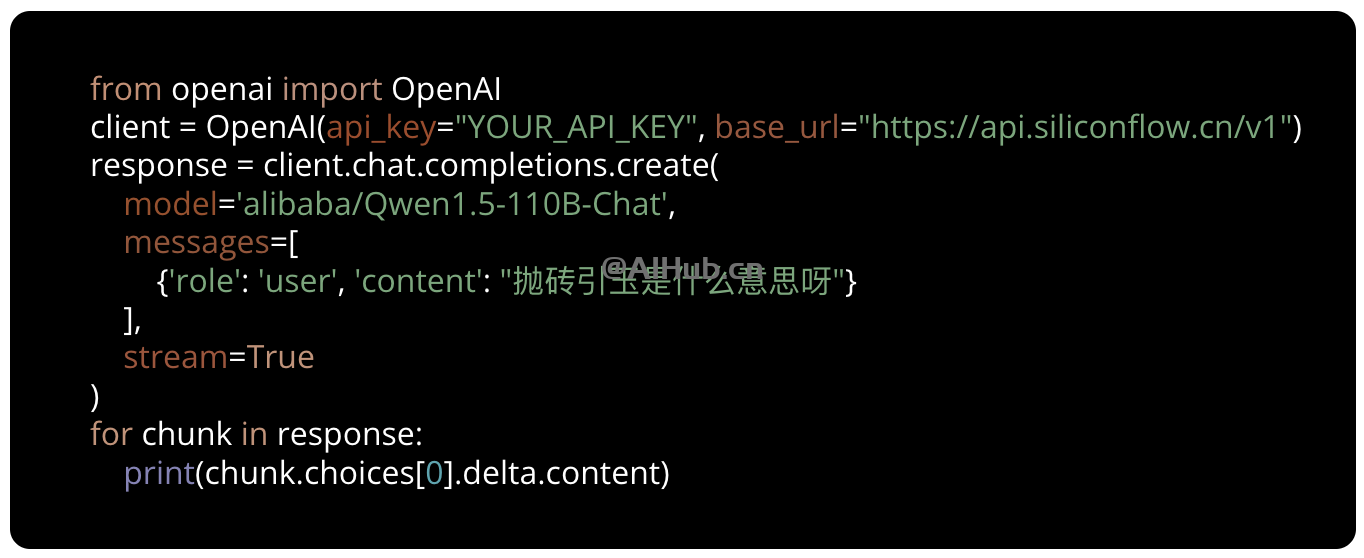

只需一行代码,开发者即可快速迁移到SiliconCloud的快速模型服务上。

如何使用SiliconCloud?

1. 访问 SiliconCloud 官网 完成注册/登录。

2. 登录后,进入“体验中心”页面,点击右侧的“模型(Model)”可自由切换平台目前支持的任一模型。

同时,在体验中心,你还可以直接体验 SiliconCloud 平台提供的各种模型的效果与速度。

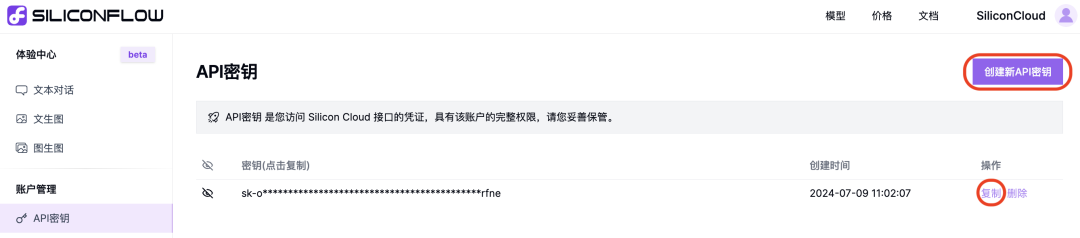

比如,可以选择 DeepSeek-V2-Chat,基于平台默认参数或提示词,点击“运行”按钮,即可看到模型生成的结果与输出速度。3. SiliconCloud API 文档3.1 生成 API 密钥点击“API 密钥”,“创建新 API 密钥”并复制密钥,以在你的 API 场景中使用。

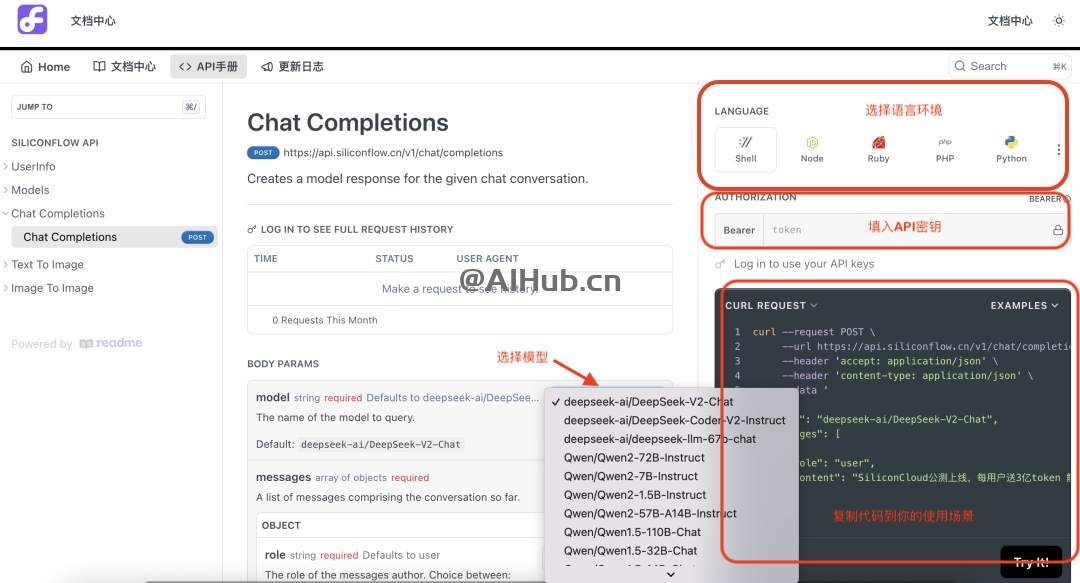

3.2 跳转到文档中心

点击页面右上角的“文档”,跳转至“文档中心”页面。

3.3 进入“API 手册” 选择想接入的模型与语言,填入你的 API 密钥 ,生成对应语言的代码,复制代码到你的使用场景。

至此,你就可以在自己的应用场景中享用 SiliconCloud 的 API 服务了。