AIHub 最新消息 12月26日,深言科技“语鲸大模型”正式通过《生成式人工智能服务管理暂行办法》备案,将陆续面向社会公众开放服务。那么语鲸大模型是什么,可以做什么,如何使用呢,一起来看看。

语鲸大模型是什么?

LingoWhale-8B是由深言科技推出的语鲸系列大模型中首个开源的中英双语大语言模型,拥有约80亿参数,在数万亿token的高质量中英数据上进行预训练,具有强大的基础能力,在多个公开评测基准上均达到领先效果。在预训练阶段,模型使用8K的上下文长度进行训练,能够完成更长上下文的理解和生成任务。

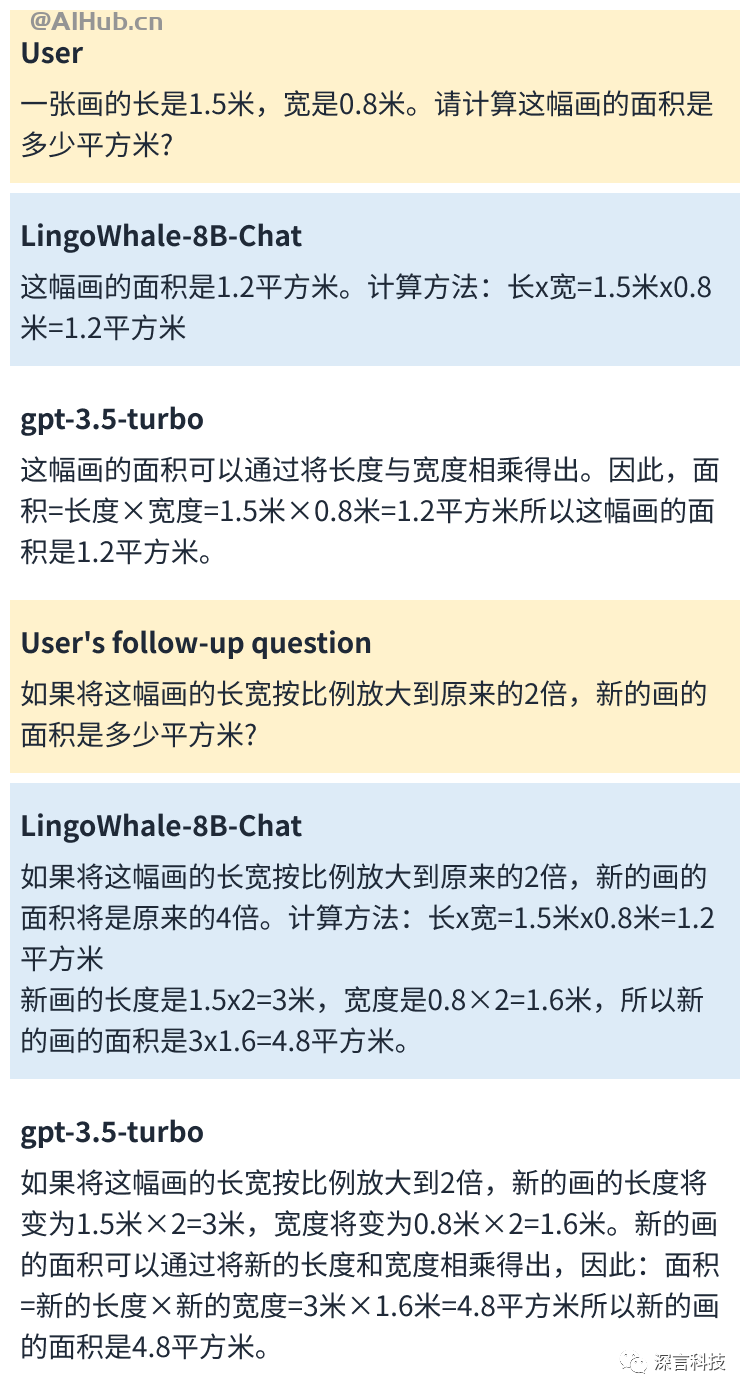

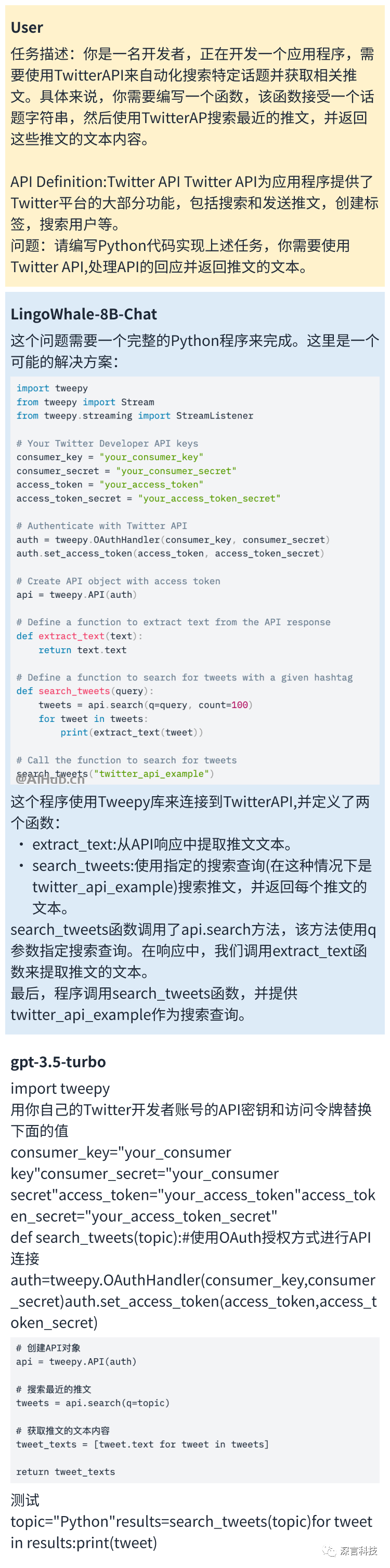

语鲸大模型可以做什么?

“语鲸大模型”具备强大的语义理解与文本生成、代码理解与生成、逻辑推理等能力,提供文本创作、数学计算、代码补全等服务,在中文理解和生成能力上行业领先,做到了更懂中文,更懂中文使用场景。

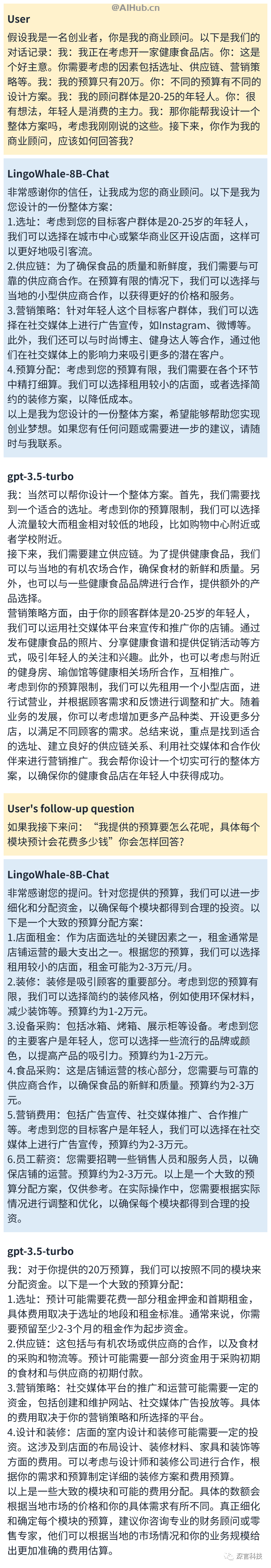

以下是深言科技提供的测试样例:

语鲸大模型测评结果

语鲸大模型在各种公开评测基准上进行了测试,比如 C-Eval、MMLU 和 CMMLU。这些评估基准提供了标准化的测试和度量,用于评估语言模型在不同任务和领域上的性能和能力。

语鲸大模型在多个公开评测基准上取得了领先效果。评测方法和测评结果如下表所示:

| Model | C-Eval | MMLU | CMMLU | GAOKAO | HumanEval | GSM8K | BBH | AGIEval |

|---|---|---|---|---|---|---|---|---|

| 5-shot | 5-shot | 5-shot | 5-shot | 0-shot | 8-shot | 3-shot | 5-shot | |

| GPT-4 | 68.4 | 83.9 | 70.3 | 66.2 | 69.5 | 90.0 | 75.1 | 63.3 |

| GPT-3.5 Turbo | 51.1 | 68.5 | 54.1 | 47.1 | 52.4 | 57.8 | 61.6 | 46.1 |

| LLaMA2-7B | 28.9 | 45.7 | 31.4 | 26.0 | 12.8 | 16.2 | 39.2 | 26.5 |

| ChatGLM2-6B* | 51.7 | 47.9 | – | – | – | 32.4 | 33.7 | – |

| Baichuan2-7B-Base* | 54.0 | 54.2 | 57.1 | 47.5 | 18.3 | 24.5 | 41.6 | 42.7 |

| Qwen-7B v1.1* | 63.5 | 58.2 | 62.2 | – | 29.9 | 51.7 | 45.0 | – |

| LingoWhale-8B-base | 63.6 | 60.2 | 62.8 | 50.3 | 32.9 | 55.0 | 47.5 | 43.8 |

*表示其模型结果来自于官方, 所有的结果都精确到小数点后1位。

如何使用语鲸大模型?

语鲸大模型模型已经开源,供学术研究免费使用,商业用途需要通过申请获取授权。

在开源模型权重的同时,语鲸大模型也提供了符合用户习惯的Huggingface推理接口以及LoRA等参数高效微调示例,便于开发者快速使用LingoWhale-8B模型。

开源地址:

- GitHub:https://github.com/DeepLangAI/LingoWhale-8B

- Huggingface:https://huggingface.co/deeplang-ai/LingoWhale-8B

- ModelScope:https://www.modelscope.cn/models/DeepLang/LingoWhale-8B

- Wisemodel:https://wisemodel.cn/models/DeepLang/LingoWhale-8B

若你期望将此源模型或其衍生品用作商业用途,请填写问卷进行申请,通过后即可免费商用。

关于深言科技

深言科技官网:https://deeplang.ai/

深言科技(DeepLang AI)由清华大学计算机系自然语言处理实验室(THUNLP)与北京智源人工智能研究院(BAAI)共同孵化,是国内最早开展大模型研发与探索大模型落地的创业公司之一。

公司创始团队曾深度参与智源·悟道大模型的研发,目前已发布产品包括世界首个中文及跨语言反向词典WantWords、名句语义检索系统WantQuotes、智能写作工具深言达意等,已为超过800万用户提供智能文本信息处理服务。

公司成立以来已获得多项荣誉,包括入选《中国企业家》大模型新锐9名单、中国最具价值 AGI 创新机构 TOP 50、第十一届中国创新创业大赛(初创组)优秀企业等,并已入选北京市通用人工智能产业创新伙伴计划。

Warning: Trying to access array offset on value of type bool in /www/wwwroot/ainvp.com/wp-content/themes/onenav/inc/clipimage.php on line 34

Warning: Trying to access array offset on value of type bool in /www/wwwroot/ainvp.com/wp-content/themes/onenav/inc/clipimage.php on line 34